¿Hay que etiquetar los vídeos generados con IA? ¿Qué pasa si no lo hago? Preguntas y respuestas sobre la nueva normativa española

Estas son las principales novedades que introduce el anteproyecto de ley sobre gobernanza de la inteligencia artificial

El Consejo de Ministros presentó el pasado martes el Anteproyecto de ley para el buen uso y la gobernanza de la inteligencia artificial (IA), que regula la aplicación práctica de esta tecnología. El documento desarrolla lo establecido en el Reglamento Europeo de Inteligencia Artificial, acordado por las instituciones comunitarias el 8 de diciembre de 2023 y aprobado por el Parlamento Europeo el 13 de marzo del año pasado.

El texto del anteproyecto de ley, abierto a consulta pública desde este martes por la tarde, concreta algunas de las cuestiones incluidas en el reglamento y las adapta a nuestro ordenamiento jurídico. Establece qué aplicaciones de IA están prohibidas, cuáles se pueden usar con permiso y cuáles no necesitan ser supervisadas. En el caso de los sistemas de reconocimiento biométrico en tiempo real, los que más controversia despertaron durante la negociación del reglamento, se indica en qué casos excepcionales podrán las autoridades autorizar su uso.

También se fija un régimen sancionador y un esquema de sanciones, además de concretar qué organismos se encargarán de cerciorarse de que se cumpla la normativa, y se tendrán que identificar los contenidos generados con IA.

¿A qué obligará exactamente la nueva normativa? ¿Cuándo será de aplicación? ¿Qué multas se contemplan para quienes vulneren la ley? Estas son las novedades que introducirá en nuestra legislación el anteproyecto de ley sobre IA cuando sea aprobado definitivamente.

¿Cuándo se empezará a aplicar?

El Anteproyecto de ley para el buen uso y la gobernanza de la inteligencia artificial, que se tramitará por la vía de urgencia, debe volver al Consejo de Ministros tras el periodo de consulta pública previa, que finaliza el 26 de marzo (durará solo ocho días) y, posteriormente, pasar por las Cortes para que le dé luz verde. El texto podría modificarse durante el proceso, aunque difícilmente lo hará de forma sustancial. Debería entrar en vigor en la primera mitad de este año, en tanto que se establecen algunos deberes, como la elaboración de informes, para agosto de 2025.

¿Qué obligaciones establece?

La nueva normativa desarrolla el Reglamento Europeo de IA, que a su vez estableció un enfoque de clasificación de las aplicaciones de IA de acuerdo con el riesgo que suponen para la sociedad. Así, son de “riesgo inaceptable”, y, por tanto, están prohibidos, los sistemas que trasciendan la conciencia de una persona o técnicas deliberadamente manipuladoras, los que exploten sus vulnerabilidades o las que infieran emociones, raza u opiniones políticas de las personas.

Quedan encuadrados en la categoría de “alto riesgo”, que implica una supervisión constante por parte de las autoridades, los sistemas de identificación biométrica remota en diferido, los sistemas de categorización biométrica o el reconocimiento de emociones. También los sistemas que afecten a la seguridad de las infraestructuras críticas y los relacionados con la educación (evaluación de comportamientos, sistemas de admisión y exámenes), el empleo (selección de personal) y la prestación de servicios públicos esenciales, la aplicación de la ley o la gestión de la migración.

El resto de aplicaciones se consideran de “bajo riesgo” y se pueden manejar sin restricciones. La normativa prevé la creación de un registro nacional de sistemas de IA en el que quedarán referenciados los de “alto riesgo”.

¿Cuándo se puede usar el reconocimiento facial en tiempo real?

Los sistemas automáticos de reconocimiento facial se pueden usar en España en algunos casos y siempre que se cuente con el consentimiento de los ciudadanos a quienes afecta. La Policía, por ejemplo, recurre a esta tecnología para avanzar en algunas investigaciones. Con un matiz importante: no se pueden usar en espacios públicos en tiempo real (por ejemplo, para identificar o buscar a alguien que pase por la calle).

El anteproyecto de ley le dedica un capítulo entero a los sistemas de identificación biométrica (un término que engloba el reconocimiento facial y otras tecnologías) remota en tiempo real, que “están prohibidos, salvo que su uso sea estrictamente necesario”. El Anexo II del anteproyecto de lay fija estos motivos que justificarían su uso: la “búsqueda selectiva de víctimas concretas de secuestro, trata de seres humanos o explotación sexual”, así como “personas desaparecidas”, la “prevención de una amenaza específica, importante e inminente para la vida o la seguridad física de las personas físicas o de una amenaza real y actual o real y previsible de un atentado terrorista”, y la “localización o identificación de una persona sospechosa de haber cometido un delito” grave, como terrorismo, trata de seres humanos, explotación sexual de menores, homicidio, secuestro o violación.

La autoridad interesada en usar estos sistemas deberá formular una autorización “para cada caso de uso” en la que se especifiquen los motivos de urgencia, qué persona o personas se quiere identificar, en qué ámbito geográfico y temporal y en qué hechos se apoya la solicitud. Se deberá dar respuesta a la misma en un máximo de 48 horas. En caso de desestimarse la autorización, “se interrumpirá inmediatamente el uso y desechará y suprimirá inmediatamente todos los resultados obtenidos”.

Los encargados de autorizar o no el uso de los sistemas biométricos remotos en tiempo real serán los juzgados de lo contencioso-administrativo.

¿Quién controlará que se cumpla la normativa?

Agencia Española de Supervisión de Inteligencia Artificial (Aesia) centralizará la vigilancia de los algoritmos. Con todo, la gestión y tratamiento de datos biométricos será responsabilidad de la Agencia Española de Protección de Datos (AEPD); los sistemas de IA que puedan afectar a la democracia serán competencia de la Junta Electoral Central; y del Consejo General de Poder Judicial dependerán los que puedan incidir en la aplicación de la justicia.

Cuando la autoridad de vigilancia estime que un sistema de IA no clasificado como de alto riesgo lo pueda ser, se iniciará un proceso de revisión que deberá resolverse en 72 horas. Asimismo, “cualquier ciudadano, mediante una información anónima, puede dar lugar al inicio del expediente sancionador”, siendo la Aesia la encargada de centralizar estas denuncias.

Los primeros informes anuales sobre el uso de sistemas de identificación biométrica remota en tiempo real o en diferido deberán publicarse antes del 31 de diciembre de este año. Asimismo, la Aesia deberá publicar un primer informe antes del 2 de agosto “sobre el estado de los recursos financieros y humanos” de las autoridades nacionales competentes.

El nuevo presidente de la AEPD, Lorenzo Cotino, dijo la semana pasada en una reunión con periodistas al que asistió este periódico que, para hacer frente a las nuevas tareas que le encomienda este anteproyecto de ley, la Agencia necesitará un aumento de personal.

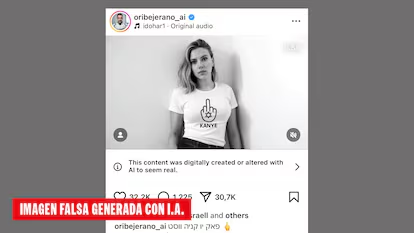

¿Cómo hay que etiquetar los contenidos generados por IA?

El anteproyecto de ley establece que, “cuando los sistemas de IA generen contenido sintético de audio, imagen, video o texto”, se deberá “marcar los resultados de salida de tal modo que pueda detectarse su naturaleza artificial”. No se especifica cómo debe ser ese etiquetado, pero sí las sanciones que puede acarrear el no hacerlo (ver apartado siguiente).

También será obligatorio informar a las personas físicas de su exposición a un sistema de reconocimiento de emociones o de categorización biométrica.

¿Cómo se penaliza el incumplimiento?

Las infracciones “muy graves” supondrán una multa de entre 7,5 y 35 millones de euros, o entre el 2% y el 7% del volumen de negocios anual mundial. Entran en este supuesto el uso de tecnologías prohibidas, de sistemas de identificación biométrica remota en tiempo real no autorizados, no eliminar los datos de esa identificación si lo requieren las autoridades o no notificar que se está usando esa tecnología.

Las infracciones “graves” se penan con entre 7,5 y 15 millones de euros, o entre el 2% y el 3% del volumen de negocios anual mundial. No ponerle marca de agua a un contenido generado por IA, resistirse a aplicar medidas provisionales impuestas por las autoridades o introducir en el mercado aplicaciones de “alto riesgo” sin registrarlas previamente entra en esta categoría.

En un tercer escalón están las infracciones “leves”, que comportan multas de entre 6.000 y 500.000 euros, o entre el 0,5% y el 1% del volumen de negocios anual mundial, y que básicamente se impondrán en caso de facilitar información “incompleta inexacta o engañosa” cuando las autoridades lo requieran.

La cosa cambia cuando quienes cometen la infracción son las autoridades: en ese caso, los castigos son mucho más suaves. Tanto, que algunos juristas, como Borja Adsuara, lo consideran escandaloso. “¿Para qué incluir en el anexo usos prohibidos por la Administración si no hay ninguna consecuencia? No conozco ni una sanción ni una amonestación a un funcionario o autoridad por un mal tratamiento de datos personales. Con la IA pasará lo mismo”, se queja este experto en derecho digital.

Así, el anteproyecto de ley establece que se apercibirá a la entidad actuante y se podrán establecer “las medidas que proceda adoptar para que cese la conducta o se corrijan los efectos de la infracción que se hubiese cometido, excluyendo la imposición de multas administrativas”. Al margen de ello, se contemplan “actuaciones disciplinarias cuando existan indicios suficientes para ello”. En caso de que alguna autoridad pública haga un mal uso de la IA desoyendo informes técnicos previos, se amonestará a los responsables.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.

Sobre la firma